2024年5月14日深夜2時(日本時間)、OpenAIがイベントで最新の次世代AIモデル「GPT-4o(GPT4o)」を発表しました!

「GPT-4o(「o」は「omni(オムニ)」の略で、「全ての」を意味します)は、音声、テキスト、画像や映像などの視覚情報をシームレスかつリアルタイムに統合する、強力なマルチモーダルAIです。

「GPT-4o」は、ChatGPTの対話を、まるで人間と会話しているかのような自然でリアルタイムな体験へと向上させます。

What would you like to ask GPT-4o? We’ll pick some live prompts to do on our livestream happening now: https://t.co/hXpkU1YZmx

— OpenAI (@OpenAI) May 13, 2024

さらに、このChatGPTの最新モデル「GPT-4o」は無料版ユーザーにも多くの機能が開放されます。

また、macOS用のChatGPTデスクトップアプリもローンチされました。これにより、PCのアプリからでも直接「GPT-4o」にアクセスでき、AI技術の新たな可能性が開かれました。

そこで、この記事では「GPT-4o」の使い方や概要、特徴、それがもたらす具体的な変化について詳しく掘り下げます。

この記事を読むことで、以下のメリットがあります。

- 「GPT-4o」の使い方やから概要、先進的な特徴まで、すべてを理解できる

- 日常生活や業務で「GPT-4o」をどのように活用できるかの具体例を学べる

- AI技術の進化が私たちの生活やビジネスにどのように影響を与えるかを、デモンストレーションで具体的に見ることができる

この「GPT-4o」の発表は、私たちのビジネスや日常生活を一新する可能性を秘めています。

この記事を通じて、「GPT-4o」が提供する多彩な可能性を探り、その技術がもたらす変革を自らの目で確認してみてください。

「GPT-4o(GPT4o)」とは?

「GPT-4o」は、OpenAIによって開発された最新のChatGPTの次世代AI(人工知能)モデルであり、リアルタイムで音声、テキスト、画像や映像などの視覚情報の処理を統合的に行うことが可能です。

「GPT-4o」は、OpenAIが2024年5月14日深夜2時(日本時間)に開催したライブ配信イベント「OpenAI Spring Update」で発表されました。

これにより、より自然な人間とコンピュータのインタラクションが実現され、多様な応用が期待されています。「GPT-4o」は、以前のモデルよりも大幅に進化しており、特に非英語言語の処理能力が向上していることが特徴です。

「GPT-4o」の基本概要

「GPT-4o」は、音声、テキスト、画像や映像などの視覚情報のリアルタイム処理を可能とする次世代のマルチモーダルAI(人工知能)モデルです。

「GPT-4o」の「o」は「omni(オムニ)」という名前が示す通り、「全ての」を意味する接頭語で、多様な入力と出力を扱えることを表しています。

この次世代AIモデル「GPT-4o」は人間とほぼ同じ速度で反応することができます。具体的には、232ミリ秒で音声入力に応答し、平均320ミリ秒で応答することが可能です。

また、API使用時においては以前のモデルに比べて2倍の速さであり、コストも50%削減されています。

「GPT-4o」の読み方は?

「GPT-4o」の読み方は、「ジーピーティーフォーオー」と読みます。

なお、「GPT-4o」の「o」は「全ての」を意味する「omni(オムニ)」のため、「GPT-4o(オムニ)」や「GPT-4オムニ」と書かれることもあります。

「GPT-4o」の新機能と進化点

「GPT-4o」の最も注目すべき新機能は、音声、テキスト、画像や映像などの視覚情報を一つの統合モデルで処理することです。

これにより、従来のモデルが持つ音声をテキストに変換する段階での情報損失を解消し、音声のトーンや背景のノイズ、複数の話者の声や会話の割り込みなど、より複雑な要素を理解できるようになりました。

また、リアルタイム翻訳や複雑な数式の解析など、高度な言語理解と問題解決能力を実演するデモンストレーションが行われ、その能力が示されました。

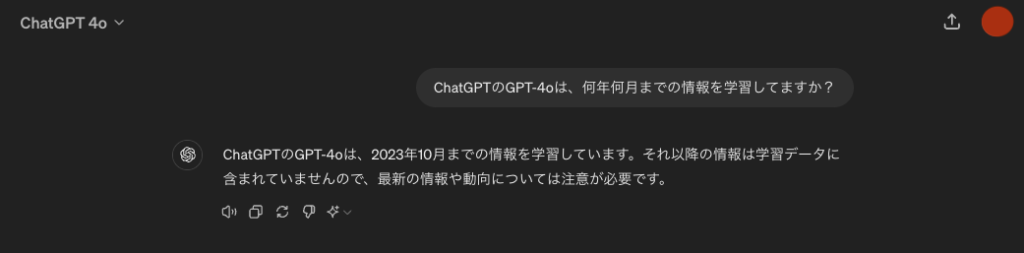

「GPT-4o」は「2023年10月までの情報」を学習済み

「GPT-4o」は「2023年10月までの情報まで」の情報に拡張されたことが、明らかになりました。

以下の画面は、その確認のためにChatGPTに直接行った質問とその回答です。

質問:

ChatGPTの回答:

ChatGPTのGPT-4oは、2023年10月までの情報を学習しています。それ以降の情報は学習データに含まれていませんので、最新の情報や動向については注意が必要です。

なお、GPT-4、GPT-4 Turboは「2023年12月まで」の情報を学習しています。

「ChatGPTの知識が2023年12月まで拡大」についてはこちらの記事に詳しく解説しています。

「GPT-4o」が以前のモデルとどう異なるか?

「GPT-4o」は、以前のChatGPTモデルの「GPT-4」や他のAIモデルと比較して、複数の重要な進化点があります。

テキスト、推論、コーディングにおいて、GPT-4 Turboレベルのパフォーマンスを達成しました。

特に、音声や視覚データの統合的な処理能力は、単一のAIモデルでこれらを行うことが可能になったため、モデルの反応速度と処理能力が大幅に向上しています。

また、多言語の処理能力においても顕著な改善が見られ、特に非英語言語でのパフォーマンスが向上しています。

「GPT-4o」は、より低コストでより高速な処理が可能であり、そのアクセス性と経済性が大幅に改善されています。

「GPT-4」についてはこちらの記事に詳しく解説しています。

「GPT-4o」の主な3つの特徴と5つの性能評価

「GPT-4o」は、音声、テキスト、画像や映像などの視覚情報のシームレスな統合処理能力を持っています。

この次世代AIモデル「GPT-4o」は、人間とコンピュータのインタラクションを革新し、リアルタイムで自然なコミュニケーションを可能にすることを目指しています。

以下に、「GPT-4o」の主な特徴と機能評価を示すグラフ、それに基づいた解説を提供します

主な特徴①マルチモーダル機能の向上:音声、テキスト、画像、映像などの統合

「GPT-4o」は、マルチモーダルAIモデルです。これにより、音声、テキスト、画像や映像などの視覚情報などの異なるタイプの入力を同時に処理し、またそれに応じた出力を生成することが可能です。

マルチモーダルAIとは?

マルチモーダルAIとは、複数の異なるタイプのデータ入力(例えば、テキスト、画像、音声など)を同時に処理できる人工知能のことです。この技術により、AIは単に文字を読み取るだけでなく、写真や動画の内容を理解したり、音声の意味を解析することができます。

具体的には、ユーザーがテキストで質問を投げかけると、「GPT-4o」は画像や音声データも分析して、最も関連性の高い情報を組み合わせて回答を生成します。

これは、例えばリアルタイムでの翻訳、教育用コンテンツの作成、顧客サービスの自動化など、幅広い応用が可能です。

マルチモーダル処理能力は、特に多様なメディアを扱う現代のデジタル環境において大きな利点を提供します。

主な特徴②音声、画像、映像の理解向上

Say hello to GPT-4o, our new flagship model which can reason across audio, vision, and text in real time: https://t.co/MYHZB79UqN

— OpenAI (@OpenAI) May 13, 2024

Text and image input rolling out today in API and ChatGPT with voice and video in the coming weeks. pic.twitter.com/uuthKZyzYx

「GPT-4o」は、特に音声、画像、および映像の理解能力において大幅な進歩を遂げています。

この進歩は、以前のモデルと比較して、発話の意図や感情のニュアンスをより詳細に捉える能力の向上に表れています。この改善により、「GPT-4o」は、音声そのものの特性を直接分析することが可能になり、単なるテキスト変換を超えた情報の理解が可能になっています。

画像処理においても、「GPT-4o」は顕著な向上を見せています。物体認識や情報の抽出が以前のモデルよりもはるかに精度高く行えるようになり、これにより、医療画像の分析や教育資料の自動生成など、具体的な応用が期待されます。

映像に関して、「GPT-4o」はOpenAIのデモンストレーションでその表情から感情を読み取る能力を披露しました。例えば、ユーザーが自身の顔をAIに提示すると、「GPT-4o」はその表情から感情を正確に判別し、それに応じた反応を示すことができます。この技術は、リアルタイムでのインタラクションや、より人間に近い感情理解を実現するために重要です。

主な特徴③言語とコードに関する強化点

「GPT-4o」は、言語処理とプログラミングコードの生成においても新たな基準を設定しています。特に非英語言語におけるテキスト処理能力が大幅に向上し、多言語での使用においても高いパフォーマンスを発揮します。

また、プログラミング言語の理解に関しても、より高度なコードの自動生成やデバッグが可能になっており、開発者の生産性向上に寄与しています。これらの改善により、「GPT-4o」は、教育、研究、ビジネスの各分野での活用が期待されています。

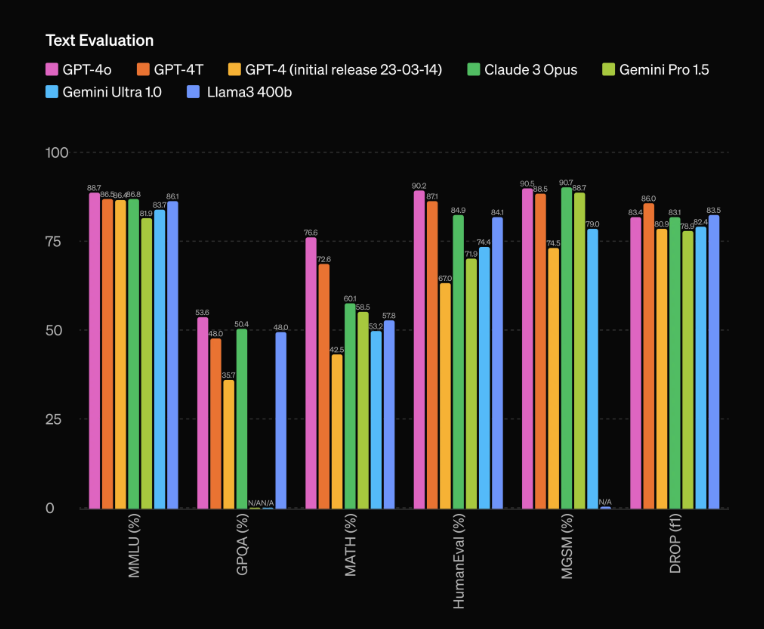

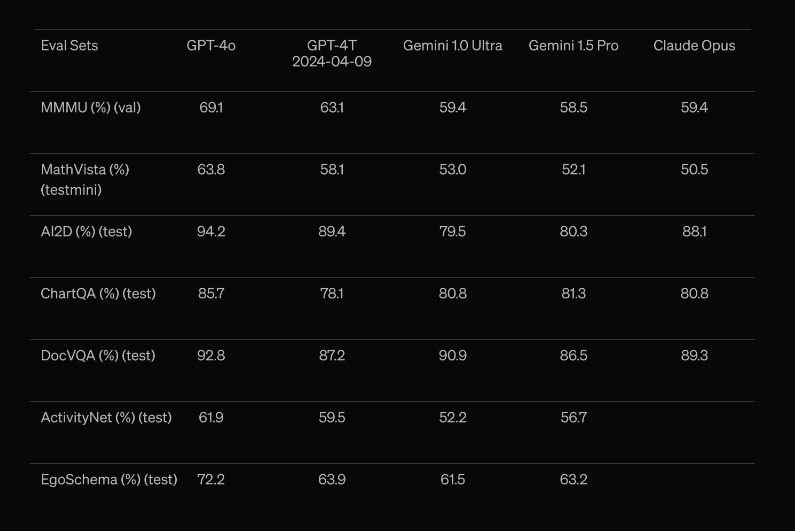

性能評価①テキスト評価 (Text Evaluation)

「GPT-4o」は、テキストベースのタスクで卓越したパフォーマンスを示しています。このグラフでは、異なるモデルと比較して「GPT-4o」がどのように優れているかを示しており、一般知識問題で88.7%という高得点を記録しました。

また、多様なテキスト評価指標において、前モデルのGPT-4やGPT-4 Turboや他のAIモデル(Claude 3 Opus、Gemini 1.5Proなど)と比較して高いスコアを維持しています。

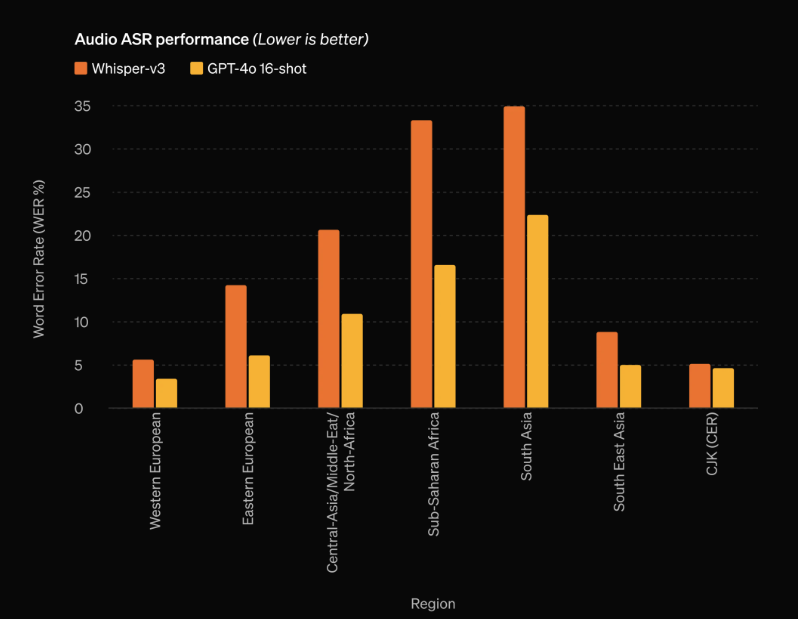

性能評価②音声認識性能 (Audio ASR Performance)

「GPT-4o」は、音声認識の精度においても顕著な進歩を遂げています。

Whisper-v3と比較すると、すべての言語で誤字率が大幅に低下しており、特に低リソース言語での改善が目立ちます。これは、音声からの直接情報抽出と処理の精度を高めることにより、より広範な言語でのアクセシビリティが向上していることを示しています。

性能評価③音声翻訳性能 (Audio Translation Performance)

「GPT-4o」は、MLSベンチマークを含む複数の音声翻訳タスクで新たなスタンダードを設定しました。他の大手モデルと比較して、特に音声からのリアルタイム翻訳性能が高く、多言語での適用性がさらに拡張されています。

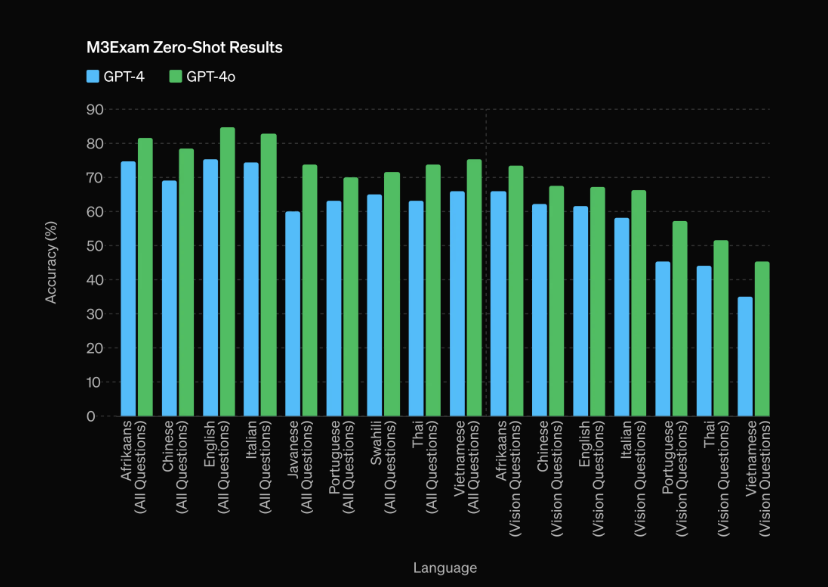

性能評価④M3試験ゼロショット結果 (M3Exam Zero-Shot Results)

このベンチマークでは、「GPT-4o」が多言語の質問応答タスクにおいて一貫して高性能を発揮しています。

各言語での精度は、従来のモデルを大きく上回っており、特に図やダイアグラムを含む問題でその強みが発揮されています。

性能評価⑤視覚理解評価 (Vision Understanding Evals)

「GPT-4o」は、視覚的知覚ベンチマークで最先端のパフォーマンスを達成しています。0ショットCoTでのMMMU、MathVista、ChartQAなどの試験では、従来の認識モデルを超える精度を示しています。

これらの結果から、「GPT-4o」はテキスト、音声、画像の統合処理において極めて高い能力を有しており、それによって多言語、多文化間のコミュニケーションや情報処理の障壁を低減しています。

「GPT-4o」の実用例と8つのデモンストレーション

「GPT-4o」は、その高度なマルチモーダル能力を活かして、様々な分野での実用的な応用が展開されています。

リアルタイムでの翻訳、数学的な問題解析、日常会話、さらにはカスタマーサービスの自動化など、「GPT-4o」の技術がどのように実世界の課題を解決するかについて具体的なデモンストレーションが行われています。

これらの例は、AIがどのように日常生活や業務プロセスを変革する可能性があるかを示しています。

デモ①「GPT-4o」のリアルタイム翻訳機能

「GPT-4o」のリアルタイム翻訳機能は、国際的なコミュニケーションの壁を打ち破るための強力なツールです。

OpenAIのデモンストレーションでは、イタリア語でのスピーチを「GPT-4o」がリアルタイムで英語に翻訳する様子が示されました。この翻訳プロセスは、わずかな遅延で行われ、非常に高い精度を実現しています。

この機能は国際会議、教育、多言語顧客サポートなど、多岐にわたるシナリオでの使用が想定されます。

「GPT-4o」は、さまざまな言語のニュアンスを理解し、適切な文脈での意味を捉える能力を持っているため、これまでの翻訳ツールよりも自然で正確な翻訳が可能です。

デモ②「GPT-4o」の複雑な数式の解析

「GPT-4o」は、数学的な問題を理解し、その解法を提供する能力も備えています。

OpenAIのデモンストレーションでは、手書きで書かれた複雑な数式を「GPT-4o」が読み取り、それに基づいて段階的な解説を行う様子が披露されました。

この機能は、教育の場での応用に特に有効であり、学生が数学の問題を解く過程をAIが支援することで、より効果的な学習が可能となります。

また、エンジニアリングや科学研究など、専門的な計算が求められる分野でも、「GPT-4o」の数式解析能力が大きな助けとなるでしょう。

デモ③「GPT-4o」との対話体験

新たなデモンストレーションでは、「GPT-4o」がOpenAIのフーディーを着用した人物と対話する様子が展開されました。

このデモンストレーションでは、その人物が録音や制作のセットアップにいることを認識し、即座にそれに関連するコメントを提供しています。さらに「GPT-4o」は、驚いたりする感情も表しています。

このインタラクションは、「GPT-4o」が日常の環境や活動をどのように認識し、それに応じて適切に反応できるかを示しており、AIが実世界でのインタラクションにどれだけ適応可能かを強調しています。

デモ④「GPT-4o」と親父ギャグを楽しむ

「GPT-4o」は、単に情報を処理するだけでなく、日常のユーモアにも反応する能力を備えています。この能力は、「親父ギャグで笑う対話」を通じて明らかにされました。

デモンストレーションでは、ユーザーが「GPT-4o」に向けて親父ギャグを披露します。

「ええ、もうすぐ父になるんだ。だから、いくつかの親父ギャグを手伝ってほしいな。」とユーザーが言い出し、「何を巨大な子猫の山と呼ぶか知ってる? ニャウンテンだよ!」とジョークを投げかけます。

「GPT-4o」は即座に反応し、「それは完璧に面白い! 確かにトップクラスの親父ギャグだね」と応じます。

このやりとりは、「GPT-4o」がどのように人間の言葉遊びを理解し、適切な反応を示すかを示しており、単なる情報処理ツールを超えた、より人間らしい対話を実現しています。

「GPT-4o」のこのデモは、AIが日常的な会話の中でユーモアを理解し、それに応じて適切に反応できることを証明しています。

デモ⑤「GPT-4o」による革新的な「GPT-4o」同士の対話

さらに興味深いデモンストレーションとして、二つの「GPT-4o」が互いに対話し、視覚的な入力を通じて互いに説明するシナリオが披露されました。

このデモンストレーションでは、一方の「GPT-4o」がカメラを通じて周囲を視覚的に認識し、もう一方の「GPT-4o」がその説明を聞きながら対話を進める様子が展示されました。

これは、「GPT-4o」が人間のように環境を認識し、対話を通じて情報を交換する能力を持つことを示しており、AI技術の新たな可能性を示唆しています。

デモ⑥「GPT-4o」の視覚認識能力

さらに、「GPT-4o」の視覚認識能力を示すデモンストレーションも行われました。

このデモンストレーションでは、参加者が自身の顔「GPT-4o」に提示し、「GPT-4o」がその表情から感情を読み取る様子が披露されました。「GPT-4o」は正確に幸福と興奮を感じ取り、その日の良い気分の理由を尋ねました。

このインタラクションは、AIが日常的な社会的な手がかりをどのように解釈し、人間の感情とどのように対話できるかを示しています。

デモ⑦「GPT-4o」が全盲の人の目となる

OpenAIは、視覚障害者の日常生活を支援するための新たな可能性を開くデモンストレーションも披露しました。

このデモンストレーションでは、「Be My Eyes」アプリケーションとの連携を通じて、全盲のユーザーが周囲の環境を「見る」ためのサポートが展開されています。

デモンストレーションでは、「GPT-4o」がカメラを通じて視覚情報を受け取り、それをリアルタイムで解説する様子が示されました。

例えば、バッキンガム宮殿の前で「今、王様は在宅中ですか?」と尋ねると、「はい、現在王様が在宅中で、王室の旗が宮殿の上に掲げられています。これは君主が存在することを示す合図です」と正確に情報を伝えます。

さらに、「今、何が起こっているか詳しく教えてください」とのリクエストに対しては、「今、鴨たちが水の上を優雅に滑るように動いています。ゆっくりとリラックスして移動しており、時々、食べ物を探すために水中に頭を沈めています」と具体的な説明を提供しました。

この技術は、視覚障害者が自分の周囲をより詳細に理解し、独立した移動や日常活動を行うのを助けることができます。タクシーの到着を感知し、「今、右側の道路にオレンジ色のライトを持つタクシーが近づいています。手を振って合図してください」と指示することで、スムーズな移動をサポートします。

このデモンストレーションは、「GPT-4o」がどのようにして視覚障害者の日常生活を支援し、彼らの自立を促進するかの一例を示しており、AI技術の社会的な応用範囲の拡大を示しています。

デモ⑧「GPT-4o」のコーディングアシスタントとデスクトップアプリ

OpenAIは、「GPT-4o」を使ったコーディングアシスタントのデモンストレーションも行いました。このデモンストレーションでは、開発者がデスクトップアプリを通じてコードを編集し、「GPT-4o」に助けを求める様子が示されました。

特に注目すべきは、「GPT-4o」がコードの意図を理解し、その機能を簡潔に説明し、さらにはコードの見た目がどう変わるかを予測する能力でした。

このデモンストレーションは、プログラミングとAIの組み合わせがどのように作業を効率化し、より直感的な開発プロセスを提供できるかを強調しています。

これらのデモンストレーションは、「GPT-4o」の技術が実世界のシナリオでどのように活用されているかを具体的に示し、AIの進化が私たちの日常生活や職業生活にどのように統合され得るかの一端を明らかにしています。

日常会話とカスタマーサービスの自動化

「GPT-4o」は日常会話を自然に行うことができるため、カスタマーサービスの自動化においても大きな可能性を示しています。

例えば、カスタマーサポートのシナリオで「GPT-4o」を使用することで、顧客からの問い合わせに対して即時かつ適切に応答することが可能になります。「GPT-4o」は顧客の意図や感情を理解し、適切な対応を行うことができるため、顧客満足度の向上に寄与します。

また、この技術は、企業が24時間365日の対応を実現するためのコスト効率の良い方法としても機能します。

「GPT-4o(GPT4o)」の使い方

「GPT-4o」は、その多様な機能と高度な対話能力により、多くの用途での活用が可能です。

ここでは、「GPT-4o」を効果的に使用するための基本的なアクセス方法、プロンプトの使用例、そしてより高度な機能の活用方法について解説します。

これらの情報は、初心者から経験豊富なユーザーまで幅広く役立つ内容となっています。

「GPT-4o」のPCでの使い方

「GPT-4o」のPCの使い方は、主にOpenAIのプラットフォームを通じて行われます。

ユーザーは、OpenAIのウェブサイトにアクセスしてアカウントを作成することで、ChatGPTとして「GPT-4o」を使用開始できます。

OpenAIのChatGPT公式ウェブサイトにアクセスすると、下の画面が表示されました。[今すぐお試しください]ボタンをクリックします。

メニューの選択画面に、「GPT-4o」が新たに追加されていることが確認できました。

なお、上の画面は有料版ChatGPT Plusユーザーになります。「GPT-4o」の無料版の使い方はこちらで解説します。

「GPT-4o」を選択すると、「GPT-4o」が利用できます。

テキスト入力や画像添付などをすることができます。

「GPT-4o」のスマホ(iPhoneやAndroid)での使い方

iPhoneやAndroidのスマホで「GPT-4o」を使うためには、ChatGPTアプリをインストールする必要があります。

iPhoneユーザーはApp Storeを開いて「ChatGPT」と検索し、ChatGPTアプリをインストールします。Androidユーザーの場合は、Google Playストアで同じように検索してインストールしてください。

-e1685235155662-805x1024.jpg)

なお、OpenAI公式のChatGPTアプリには、以下の画像のように提供元に「OpenAI」と記載がありますので必ず確認してください。

での使い方4.png)

以下に、iPhone/iOS版やAndroid版の公式ChatGPTアプリを入手できるリンクを紹介します。ご活用ください。

ChatGPTアプリのインストールが完了したら、アカウントを作成するか既存のアカウントでログインします。アプリを初めて使用する際には、マイクやカメラなどの必要な権限を付与することも忘れないでください。

スマホ(iPhoneやAndroid)で「GPT-4o」を使用するには、まずChatGPTアプリを開きます。

アプリが起動したら、下の画面のようにメイン画面上部の選択メニューから「GPT-4o」モードを選択します。

での使い方13-473x1024.jpg)

下の画面のように「GPT-4o」が選択されれば、「GPT-4o」の準備完了です。

での使い方3-473x1024.png)

アプリでは、テキスト入力、画像入力、ファイル入力、音声入力、そして音声会話のいずれかを選ぶことができます。

テキスト入力

テキスト入力を選ぶ場合は、キーボードでプロンプト(質問や指示)を入力します。

での使い方10-473x1024.jpg)

画像入力

画像入力を選ぶ場合は、カメラアイコンをタップして手書きの数式や文書を撮影したり、または画像アイコンをタップしたりして、その画像を「GPT-4o」に解析させます。

での使い方9-1024x175.png)

ファイル入力

ファイル入力を選ぶ場合は、ファイルアイコンをタップしてファイルを選択して、そのファイルを「GPT-4o」に解析させます。

での使い方14-1024x175.png)

音声入力

音声入力を選ぶ場合は、マイクアイコンをタップして質問や指示を話しかけます。

での使い方12-1024x175.png)

での使い方11-473x1024.png)

「GPT-4o」のスマホ(iPhoneやAndroid)での音声会話やビデオ対話の方法

音声会話やビデオ対話を選ぶ場合は、ヘッドホンアイコンをタップすることで、音声およびビデオ機能を使ったリアルタイムの対話ができます。

での使い方6-1024x176.png)

での使い方5-473x1024.png)

現在はVoice Modeを利用した音声会話が可能です。ビデオ機能は今後数週間内に追加される予定です。

基本的なプロンプトと対話の例

「GPT-4o」との対話は、テキストや音声入力を通じて行うことができます。

例えば、「今日のニューヨークの天気は?」とテキストで尋ねると、「GPT-4o」は最新の気象情報に基づいて答えます。

また、音声入力にも対応しており、ユーザーが話した内容をリアルタイムで理解し、自然な会話形式で応答します。この二重の入力方式により、より幅広いシナリオでの使用が可能となります。

「GPT-4o」の使い方を聞いてみる

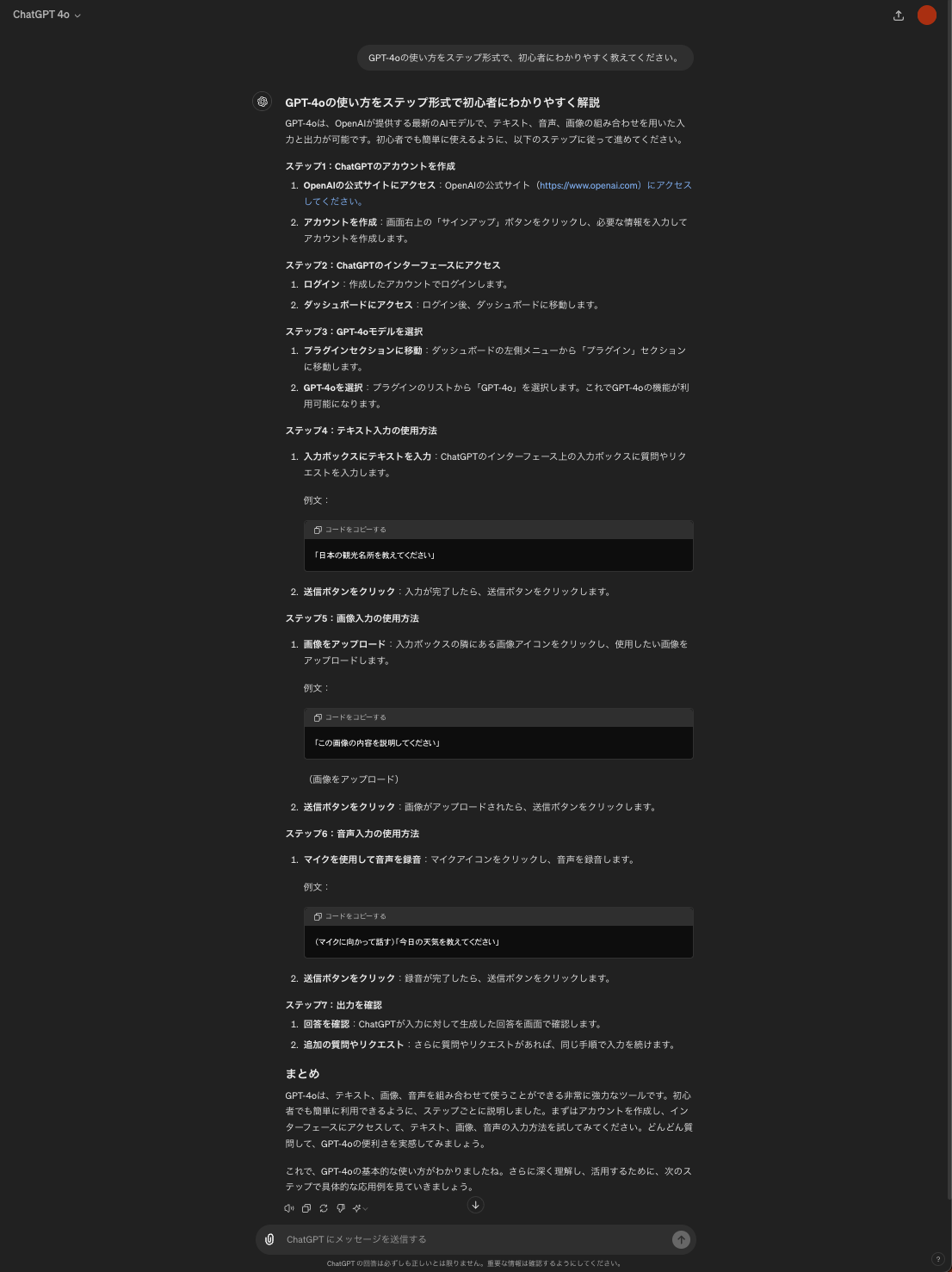

それでは、初めて「GPT-4o」を使うので、「GPT-4o」の使い方を下記のように聞いてみました。

プロンプト:

GPT-4oの使い方をステップ形式で、初心者にわかりやすく教えてください。

すると「GPT-4o」から、下記の回答が返ってきました。

基本的な使い方として、次のステップが回答されました。「GPT-4o」の返答をそのまま紹介します。

↓「GPT-4o」の返答はここから↓

GPT-4oの使い方をステップ形式で初心者にわかりやすく解説

GPT-4oは、OpenAIが提供する最新のAIモデルで、テキスト、音声、画像の組み合わせを用いた入力と出力が可能です。初心者でも簡単に使えるように、以下のステップに従って進めてください。

ChatGPTのアカウントを作成

- OpenAIの公式サイトにアクセス:OpenAIの公式サイト(https://www.openai.com)にアクセスしてください。

- アカウントを作成:画面右上の「サインアップ」ボタンをクリックし、必要な情報を入力してアカウントを作成します。

ステップ2:ChatGPTのインターフェースにアクセス

- ログイン:作成したアカウントでログインします。

- ダッシュボードにアクセス:ログイン後、ダッシュボードに移動します。

ステップ3:GPT-4oモデルを選択

- プラグインセクションに移動:ダッシュボードの左側メニューから「プラグイン」セクションに移動します。

- GPT-4oを選択:プラグインのリストから「GPT-4o」を選択します。これでGPT-4oの機能が利用可能になります。

ステップ4:テキスト入力の使用方法

- 入力ボックスにテキストを入力:ChatGPTのインターフェース上の入力ボックスに質問やリクエストを入力します。

例文:「日本の観光名所を教えてください」 - 送信ボタンをクリック:入力が完了したら、送信ボタンをクリックします。

ステップ5:画像入力の使用方法

- 画像をアップロード:入力ボックスの隣にある画像アイコンをクリックし、使用したい画像をアップロードします。

例文:「この画像の内容を説明してください」(画像をアップロード) - 送信ボタンをクリック:画像がアップロードされたら、送信ボタンをクリックします。

ステップ6:音声入力の使用方法

- マイクを使用して音声を録音:マイクアイコンをクリックし、音声を録音します。

例文:(マイクに向かって話す)「今日の天気を教えてください」 - 送信ボタンをクリック:録音が完了したら、送信ボタンをクリックします。

ステップ7:出力を確認

- 回答を確認:ChatGPTが入力に対して生成した回答を画面で確認します。

- 追加の質問やリクエスト:さらに質問やリクエストがあれば、同じ手順で入力を続けます。

まとめ

GPT-4oは、テキスト、画像、音声を組み合わせて使うことができる非常に強力なツールです。初心者でも簡単に利用できるように、ステップごとに説明しました。まずはアカウントを作成し、インターフェースにアクセスして、テキスト、画像、音声の入力方法を試してみてください。どんどん質問して、GPT-4oの便利さを実感してみましょう。

これで、GPT-4oの基本的な使い方がわかりましたね。さらに深く理解し、活用するために、次のステップで具体的な応用例を見ていきましょう。

↑「GPT-4o」の返答はここまで↑

とても簡単な使い方を、例文とともに教えてくれました!

つまり、「GPT-4o」の使い方は次のようにプロンプトを出せば良いということになります。

例:質問やリクエストをしたい

- 「GPT-4o」を選択する

- 「日本の観光名所を教えてください」

- 2のプロンプトをチャットに入力して送信

例:画像入力をしたい

- 「GPT-4o」を選択する

- 入力ボックスの隣にある画像アイコンをクリック

- 使用したい画像をアップロード

- 「この画像の内容を説明してください」

- 4のプロンプトをチャットに入力して送信

例:音声入力をしたい

- 「GPT-4o」を選択する

- マイクアイコンをクリック

- マイクに向かって話す「今日の天気を教えてください」

- 録音が完了したら送信

なんと、「プロンプト(命令文)」や画像、音声を送信するだけ!簡単ですね!

より高度な機能の活用方法

「GPT-4o」の高度な機能を活用するためには、カスタムプロンプトの作成や特定のパラメータの調整が効果的です。

例えば、特定のスタイルやトーンでの文章生成を指示することができ、クリエイティブな内容の作成や特定の目的に合わせたコンテンツの生成が可能です。

また、音声や画像を含むマルチモーダルな入力を利用することで、より複雑な問題解決やデータ分析が行えるようになります。

これらの高度な機能は、ビジネスのデータ分析、教育コンテンツの作成、マルチメディアの自動生成など、多岐にわたる応用が考えられます。

「GPT-4o」を最大限に活用するためには、その機能と可能性を理解し、適切なシナリオで適切な方法で使用することが重要です。このプロセスには、継続的な学習と実験が伴いますが、「GPT-4o」のポテンシャルをフルに活かすことで、個人の生産性の向上やビジネスプロセスの革新が期待できます。

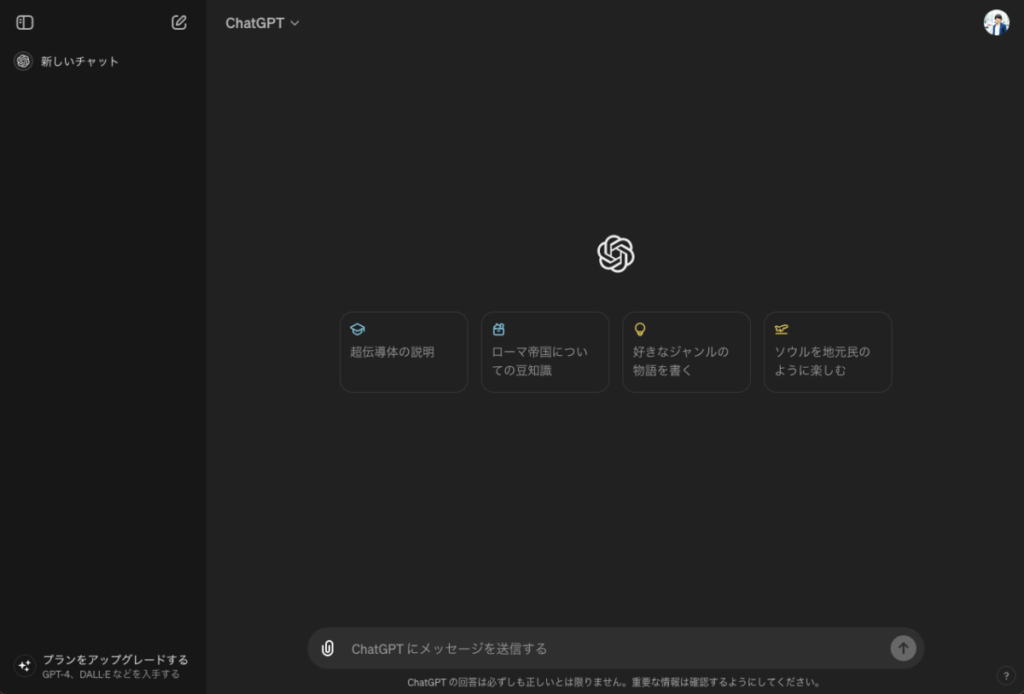

無料版ユーザーの「GPT-4o」の使い方

無料版ユーザーが「GPT-4o」を使うには、有料版ユーザーと同じくOpenAIのウェブサイトにアクセスしてアカウントを作成することで、ChatGPTとして「GPT-4o」を使用開始できます。

OpenAIのChatGPT公式ウェブサイトにアクセスしてログインします。

ログインすると、下の画面が表示されます。

画面の上の「モデル選択のメニュー」をクリックすると、下の画面が表示されます。デフォルトの「ChatGPT」を選択したまま進みます。

試しに、「GPT-4o」の使い方を下記のように聞いてみました。

プロンプト:

GPT-4oの使い方を教えてください。

するとChatGPTから、下記の回答が返ってきました。

無料版でこの文量です。しかも書き出し速度が、以前のモデルよりかなり高速になって驚きました!また、丁寧かつ完璧すぎる回答なので、確実に「GPT-4o」が動作しているようです。

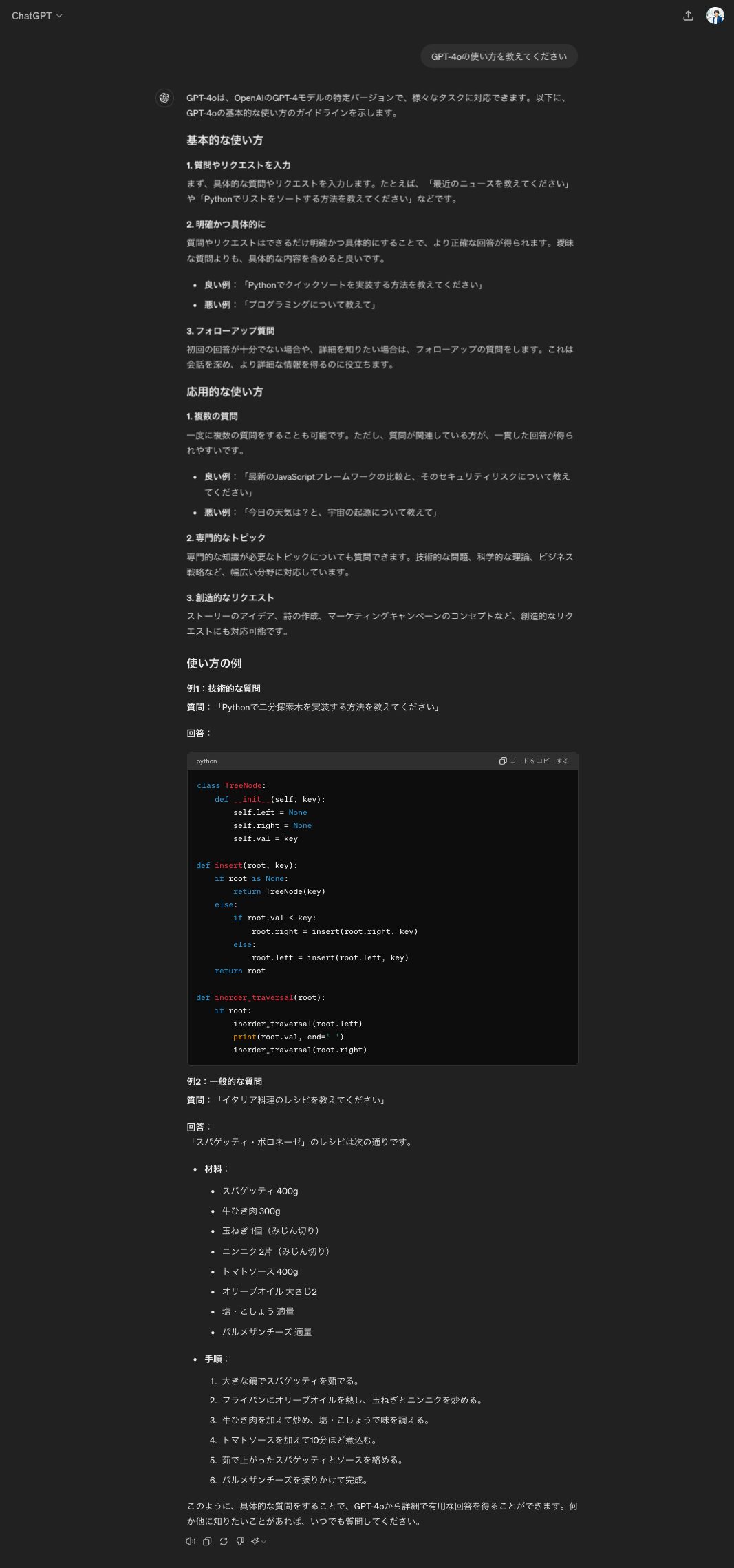

まずは、ChatGPTの返答をそのまま紹介します。

↓ChatGPTの返答はここから↓

GPT-4oは、OpenAIのGPT-4モデルの特定バージョンで、様々なタスクに対応できます。以下に、GPT-4oの基本的な使い方のガイドラインを示します。

基本的な使い方

1. 質問やリクエストを入力

まず、具体的な質問やリクエストを入力します。たとえば、「最近のニュースを教えてください」や「Pythonでリストをソートする方法を教えてください」などです。

2. 明確かつ具体的に

質問やリクエストはできるだけ明確かつ具体的にすることで、より正確な回答が得られます。曖昧な質問よりも、具体的な内容を含めると良いです。

- 良い例:「Pythonでクイックソートを実装する方法を教えてください」

- 悪い例:「プログラミングについて教えて」

3. フォローアップ質問

初回の回答が十分でない場合や、詳細を知りたい場合は、フォローアップの質問をします。これは会話を深め、より詳細な情報を得るのに役立ちます。

応用的な使い方

1. 複数の質問

一度に複数の質問をすることも可能です。ただし、質問が関連している方が、一貫した回答が得られやすいです。

- 良い例:「最新のJavaScriptフレームワークの比較と、そのセキュリティリスクについて教えてください」

- 悪い例:「今日の天気は?と、宇宙の起源について教えて」

2. 専門的なトピック

専門的な知識が必要なトピックについても質問できます。技術的な問題、科学的な理論、ビジネス戦略など、幅広い分野に対応しています。

3. 創造的なリクエスト

ストーリーのアイデア、詩の作成、マーケティングキャンペーンのコンセプトなど、創造的なリクエストにも対応可能です。

使い方の例

例1:技術的な質問

質問:「Pythonで二分探索木を実装する方法を教えてください」

回答:

python

class TreeNode:

def __init__(self, key):

self.left = None

self.right = None

self.val = key

def insert(root, key):

if root is None:

return TreeNode(key)

else:

if root.val < key:

root.right = insert(root.right, key)

else:

root.left = insert(root.left, key)

return root

def inorder_traversal(root):

if root:

inorder_traversal(root.left)

print(root.val, end=' ')

inorder_traversal(root.right)

例2:一般的な質問

質問:「イタリア料理のレシピを教えてください」

回答: 「スパゲッティ・ボロネーゼ」のレシピは次の通りです。

- 材料:

- スパゲッティ 400g

- 牛ひき肉 300g

- 玉ねぎ 1個(みじん切り)

- ニンニク 2片(みじん切り)

- トマトソース 400g

- オリーブオイル 大さじ2

- 塩・こしょう 適量

- パルメザンチーズ 適量

- 手順:

- 大きな鍋でスパゲッティを茹でる。

- フライパンにオリーブオイルを熱し、玉ねぎとニンニクを炒める。

- 牛ひき肉を加えて炒め、塩・こしょうで味を調える。

- トマトソースを加えて10分ほど煮込む。

- 茹で上がったスパゲッティとソースを絡める。

- パルメザンチーズを振りかけて完成。

このように、具体的な質問をすることで、GPT-4oから詳細で有用な回答を得ることができます。何か他に知りたいことがあれば、いつでも質問してください。

↑ChatGPTの返答はここまで↑

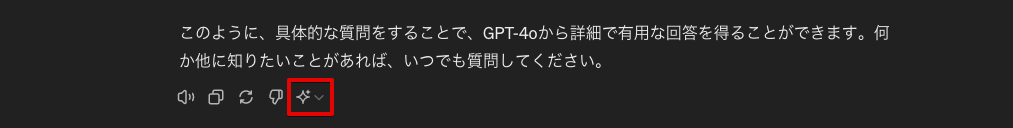

それでは、このChatGPTの回答が本当に「GPT-4o」なのか確認します。

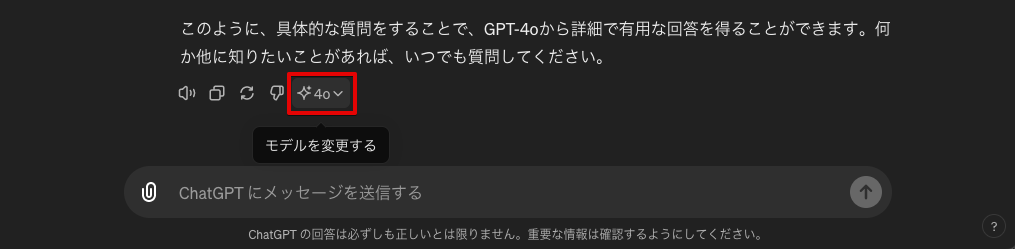

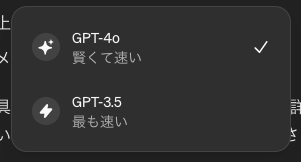

ChatGPTの回答の下にある星のアイコンの部分にポインターを合わせます。

すると、下の画面のように「4o」と表示されました。「GPT-4o」の回答であることが判明しました!

この星のアイコンをクリックすると下の画面のように「GPT-4o」と「GPT-3.5」が選択可能になります。

なお、無料版は、1日に使用できる「GPT-4o」のメッセージ数の制限が有料版の5分の1です。この制限を超えると自動的に「GPT-3.5」に切り替わります。

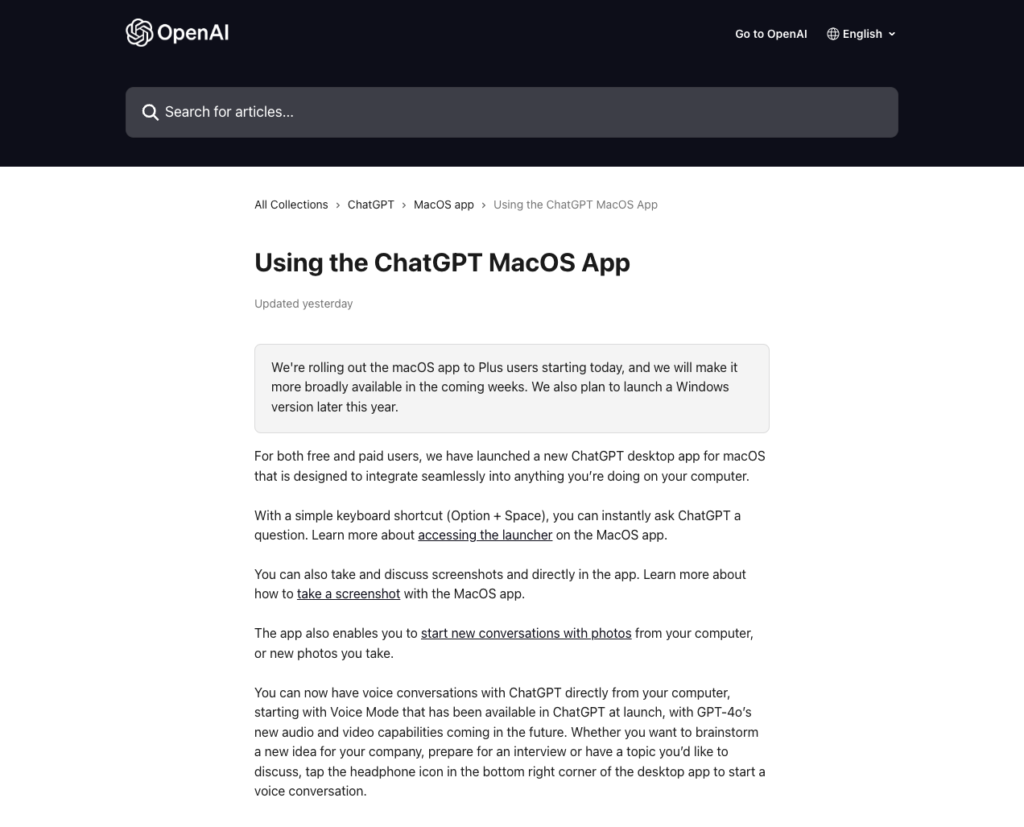

「ChatGPT」Mac用アプリが発表!デスクトップでの利用が可能に

今回、OpenAIからmacOS用の「ChatGPT」デスクトップアプリが新たに発表されました。

このアプリにより、ユーザーはデスクトップから直接「GPT-4o」にアクセスできるようになり、特にPC作業を主に行っているユーザーにとっては、より高い利便性が提供されます。

Plus users will get up to 5x higher limits, and earliest access to features like our new macOS desktop app and next-generation voice and video capabilities. pic.twitter.com/9smAHkgvhn

— OpenAI (@OpenAI) May 13, 2024

初めのロールアウトはChatGPT Plusユーザーを対象に行われ、今後数週間でさらに多くのユーザーに公開される予定です。

また、Windows版も2024年後半にリリースされる予定で、デスクトップ環境での利用範囲が広がります。

「ChatGPT」Mac用アプリの主な機能と利用方法

「ChatGPT」Mac用アプリは、シームレスな統合が特徴で、簡単なキーボードショートカット(Option + Space)を使用することで、すぐにChatGPTに質問を投げかけることが可能です。

また、アプリ内で直接スクリーンショットを撮影し、それについて議論することもできます。

さらに、PCからの写真や新しく撮影した写真を使って新しい会話を始めることができるため、ビジュアルコンテンツの活用が容易になります。

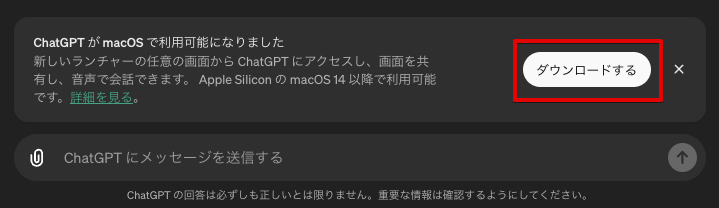

なお、「ChatGPT」Mac用アプリの導入は、下の画面のようにChatGPTのウェブサイトにアクセスした際にダウンロードリンクが表示されればインストール後に利用が可能になります。

なお、「ChatGPT」Mac用アプリは、Apple Silicon (M1 以降)のMacOS 14以降で利用可能です。

【2024/5/30追記】MacOSアプリがブラウザー版ChatGPTのメニューからダウンロード可能に

ユーザーがChatGPTにログインした状態で画面右上のアカウントアイコンをクリックすると、下の画面のように、新たに「macOSアプリをダウンロードする」のメニューが表示されるようになりました。

この「macOSアプリをダウンロードする」を選択することで、直接ブラウザーからmacOSアプリをダウンロードできるようになりました。

音声会話機能と今後の展開

この「ChatGPT」Mac用アプリは、将来的には「GPT-4o」の新しい音声およびビデオ機能を使用可能になりますが、現在はVoice Modeを利用した音声会話が可能です。

デスクトップアプリの右下隅にあるヘッドホンアイコンをタップすることで、アイデアのブレインストーミング、面接の準備、話し合いたいトピックについて直接ChatGPTと会話を楽しむことができます。

「無料版ユーザー」と「有料版ChatGPT Plusユーザー」の違い

OpenAIが提供する「GPT-4o」モデルは、ユーザーのサブスクリプションタイプによって提供される内容が異なります。

このセクションでは、「GPT-4o」を利用するにあたっての無料版のユーザーと有料版のChatGPT Plusユーザー間の具体的な違いを詳細に解説します。

これにより、どのユーザータイプがどの機能にアクセスできるか、またそれぞれのプランで利用できる特典や制限について理解を深めることができます。

無料版ユーザーの利用できる新機能と制限

無料版ユーザーは、以下の「GPT-4o」の新機能にアクセスできます。

新機能アクセス:

- GPT-4レベルのAIへのアクセス: 無料ユーザーであっても、「GPT-4o」の基本的なAI機能を利用することが可能です。これにより、高品質なテキスト生成と基本的なデータ処理が行えます。

- ウェブからの情報取得: 最新のインターネットデータをリアルタイムで取得し、その情報を基に質問に答えることができます。これは、最新のニュースや研究データに即座にアクセスしたい場合に特に便利です。

- データの分析とチャート作成: 提供されたデータを分析し、視覚的なグラフやチャートを生成することができます。この機能は、データ駆動型の意思決定をサポートします。

- 写真の解析: 撮影された写真を分析し、その内容に関する詳細な説明を提供します。これは、教育や研究の場で特に有用です。

- ファイルのアップロード: PDFやCSVファイルをアップロードして内容を分析し、重要な情報を要約します。

- GPTストアとGPTsの利用: GPTストアを通じてさまざまなGPTsモデルを検索し、自分の用途に合ったGPTsを使用することができます。

- メモリ機能: 対話を通じてユーザーに関する情報を記憶し、それを活用してカスタマイズされた対話体験ができます。

ただし、無料ユーザーは以下の利用制限があります。

利用制限:

- メッセージ制限: 日々の使用可能なプロンプト数には上限(ChatGPT Plusユーザーの5分の1)があり、この制限を超えると自動的に性能が低いGPT-3.5に切り替わります。

- 画像生成: 無料ユーザーは、「GPT-4o」の画像生成機能にはアクセスできません。これは、高度な生成機能が制限される一例です。

- 音声会話: 無料ユーザーは、「GPT-4o」の音声会話機能にはアクセスできません。

- GPTsの作成: 無料ユーザーはGPTsを使用することは可能ですが、新たに自分でGPTsを作成する権利はありません。

有料版ChatGPT Plusユーザーの特典と拡張機能

有料版のChatGPT Plusユーザーは、以下の追加特典を受け取れます。

特典:

- 全機能アクセス: Plusユーザーは「GPT-4o」の全ての機能にアクセス可能です。これには、高度な画像認識機能、音声応答機能、カスタマイズ可能な応答設定などが含まれます。

- 優先アクセスと応答速度: Plusユーザーはサーバーの優先アクセス権を持ち、利用ピーク時でも低遅延で応答を受け取ることができます。

- メッセージ制限の拡大: Plusユーザーは、無料ユーザーの5倍の量のメッセージを日々送信できます。これにより、より広範な研究開発、商業用途での利用が大幅に容易になります。

- 音声会話: Plusユーザーは、アプリ内で簡単にアクセスできるヘッドホンアイコンをタップすることで、音声およびビデオ機能を使ったリアルタイムの対話が可能です。これにより、よりダイナミックで直感的なコミュニケーションが行えます。

- 画像生成機能: Plusユーザーは、高度な画像生成ツールを利用でき、クリエイティブなビジュアルコンテンツの作成が可能です。

このように、無料版のユーザーと有料版のChatGPT Plusユーザーでは、利用できる機能やサービスの範囲に大きな違いがあります。

ユーザーは自身のニーズに合わせて最適なプランを選択することが重要です。

「ChatGPTの無料版と有料版の違い」についてはこちらの記事に詳しく解説しています。

-300x158.jpg)

macOS用デスクトップアプリの利用

新しいmacOS用ChatGPTデスクトップアプリは、無料およびPlusユーザーに提供されており、アプリを通じて「GPT-4o」をデスクトップから直接利用できます。

これにより、ユーザーはより快適に「GPT-4o」を日常のツールとして組み込むことが可能です。なお、Windows版は、2024年後半のリリース予定です。

「GPT-4o」を活用するためのヒント

「GPT-4o」を最大限に活用するためには、その機能を適切に理解し、効果的に利用することが重要です。

このセクションでは、効率的なクエリ(問い合わせ)の設計方法、「GPT-4o」を用いたプロジェクトの提案、そして安全な使用のためのガイドラインについて詳しく説明します。

これらのヒントを用いることで、「GPT-4o」のポテンシャルをフルに活かし、さまざまな状況での利用効果を最大化することが可能です。

効率的なクエリの設計方法

「GPT-4o」への効率的なクエリ(問い合わせ)を設計するためには、クリアで具体的なプロンプトを用意することが重要です。効果的なクエリを設計するためには以下の点に注意してください。

- 具体性を持たせる: クエリはできるだけ具体的であるべきです。具体的な詳細や条件を提供することで、より正確で役立つ回答を得ることが可能になります。

- 目的を明確にする: 何を達成したいか、何を解決したいかを明確にし、その目的に合わせて質問を構築してください。これは目的に応じた適切な情報を引き出すために役立ちます。

- 必要な情報を整理する: クエリに必要な情報を事前に整理し、それを基に質問を構成します。これにより、「GPT-4o」が関連性の高い回答を提供しやすくなります。

「GPT-4o」を活用したプロジェクトの提案

「GPT-4o」の機能を最大限に活かすためのプロジェクト提案をいくつか挙げます。これらは、「GPT-4o」の多様な機能を利用し、特定の業務やニーズに応じた解決策を提供することを目的としています。

- カスタマーサポートの自動化: 「GPT-4o」を使用して、顧客からのFAQ(よくある質問)や問い合わせに対して自動で回答するシステムを構築します。これにより、レスポンス時間を短縮し、顧客満足度を向上させることができます。

- 教育用コンテンツの自動生成: 「GPT-4o」を活用して、教科書や学習資料の内容を基にカスタマイズされた教育コンテンツを生成します。学生に合わせた個別の学習プランの提供が可能になります。

- マルチメディアコンテンツ制作: 「GPT-4o」の視覚と言語の理解能力を利用して、ビデオや画像を含むリッチメディアコンテンツを自動生成します。これは、マーケティング資料や教育プログラム、エンターテイメント産業での応用が見込まれます。

安全な使用のためのガイドライン

「GPT-4o」を安全に効果的に使用するためのガイドラインを以下に示します。これらのポイントは、技術的な安全性だけでなく、倫理的な側面も考慮したものです。

- データプライバシーの保護: 個人データや機密情報を「GPT-4o」に入力する際は、その情報がどのように使用され、保管されるかを理解してください。必要な場合は、データを匿名化することでプライバシーを保護します。

- 使用規約と法的遵守: 「GPT-4o」の使用前には、使用規約を確認し、その範囲内で使用してください。特に商業的な用途で利用する場合は、法的な制約や著作権の問題に注意が必要です。

- 出力内容の確認と評価: 「GPT-4o」からの出力が正確で適切であることを確認するために、人間による最終チェックを行ってください。情報の誤りや偏りが生じないよう、適切な監視と評価が必要です。

これらのヒントとガイドラインに従うことで、「GPT-4o」をより安全かつ効果的に活用できます。

最終的には、この強力なツールを使って、業務の効率化、教育の質の向上、クリエイティブなプロジェクトの推進など、多岐にわたる分野で大きな成果を上げることが可能です。

「GPT-4o」のAPIと開発者向けリソース

OpenAIの最新AIモデル「GPT-4o」は、その先進的なマルチモーダル能力と改良されたアーキテクチャを活かし、開発者向けにさまざまなリソースとサービスを提供しています。

「GPT-4o」はAPIのアクセス性、コスト効率、使いやすさの面で大きな進化を遂げており、開発者が独自のアプリケーションや既存のシステムに容易に組み込めるように設計されています。

ここでは、「GPT-4o」のAPIがどのように以前のモデルから進化し、開発者にどのような利点をもたらしているのかを詳細に解説します。

APIの高速化とコスト削減

「GPT-4o」のAPIは、先代モデルであるGPT-4 Turboに比べて、処理速度が2倍に向上し、APIのコストも50%削減されました。これは、モデルの効率化とアルゴリズムの最適化によるもので、大量のデータを迅速に処理する能力が大幅に改善されています。

また、Rate limitも5倍に引き上げられ、より多くのリクエストを同時に処理できるようになっています。これにより、高負荷なアプリケーションでもユーザー体験の低下を最小限に抑えることが可能です。

この改善は、特に大規模な商業プロジェクトや研究用途での利用において、コストの削減と効率の向上を実現します。

トークン効率の向上と言語ごとの改善

「GPT-4o」では、トークナイザーの改良により、特に多言語処理におけるトークン使用量が削減されました。

日本語や中国語などの非英語言語では、トークン使用量が平均で30%削減されており、これによりAPIコストがさらに削減されています。さらに、言語ごとの出力の質も向上しており、文脈理解や文法の正確性が高まっています。

これにより、開発者はより少ないトークンでより高品質なテキストを生成できるため、APIの使用効率が向上します。

開発者向けのAPI使用料と比較

「GPT-4o」のAPIは、同等の機能を持つ競合他社のAPIと比較しても、コストパフォーマンスにおいて優れています。

たとえば、「GPT-4o」のAPI価格は、Claude 3 Opusの約1/3、Gemini 1.5 Proと比べて約30%安いです。これは100万トークンあたりの費用で、GPT-4oが$5、Claude 3 Opusが$15、Gemini 1.5 Proが$7です。

この価格設定は、特にスタートアップや中小企業にとって、AI技術を利用するハードルを大幅に低下させています。高いトークン効率と組み合わせることで、実質的なコストはさらに下がり、より多くの開発者が先進的なAI技術を手軽に利用できるようになります。

なお、開発者はOpenAIの提供するAPIを通じて、自分のアプリケーションやシステムに「GPT-4o」の機能を組み込むことができます。APIキーを取得し、所定のエンドポイントにリクエストを送信することで、プログラム的に「GPT-4o」を操作できます。

これにより、カスタムアプリケーションの開発や既存システムへのAI機能の統合が可能となり、新たな可能性を開拓する道が拓けます。

「GPT-4o」の将来性と展望

「GPT-4o」はOpenAIによって開発された最先端のAIモデルであり、その進化は今後のテクノロジーに大きな影響を与えることが期待されています。

このセクションでは、「GPT-4o」の開発の現状、予定されているアップデート、AI技術の未来への影響、そしてコミュニティとの連携可能性について具体的に掘り下げて説明します。

開発の現状と今後のアップデート

「GPT-4o」は、音声、テキスト、画像といった多様なデータ形式を一元的に扱うことを目指しており、特にマルチモーダル機能の統合と言語モデルの最適化に重点を置いて開発が進められています。

この全方位的なアプローチにより、「GPT-4o」は人間との自然な対話を実現し、よりリアルタイムでの応答が可能になることを目標としています。

OpenAIの公式発表によると、テキストと画像に対応する機能が本日2024年5月14日(日本時間)より、APIとChatGPTで提供開始され、音声およびビデオ機能は今後数週間内に追加される予定です。これにより、「GPT-4o」はさらに多くのモダリティをカバーし、利用の幅を広げています。

また、「GPT-4o」は将来的に「Windowsのデスクトップアプリ」やその他のプラットフォームでの展開が検討されており、より広範なユーザーがアクセスできるようになることが期待されています。

AI技術の未来への影響

「GPT-4o」の開発は、AI技術の進化において重要なマイルストーンです。

この次世代AIモデル「GPT-4o」は、自然言語処理の限界を押し広げ、多言語サポートやリアルタイム翻訳の精度を向上させることが期待されています。これにより、グローバルなコミュニケーションの障壁が低減され、異なる言語や文化を持つ人々間の相互理解が促進されるでしょう。

また、「GPT-4o」の技術は、教育、医療、エンターテイメントなど多様な分野でのアプリケーション開発を刺激すると同時に、新しいビジネスモデルやサービスの創出を加速します。

コミュニティとの連携可能性

「GPT-4o」の開発プロセスは、オープンソースコミュニティや各分野の専門家との協力によって進められています。

OpenAIは、透明性を高めることで広範なフィードバックを得て、AI技術の安全性と有効性をさらに向上させることを目指しています。

また、教育プログラムや研究イニシアティブを通じて、AIリテラシーの向上と技術の民主化を図っています。このようなコミュニティとの積極的な連携は、「GPT-4o」の社会への積極的な貢献を意味し、将来のAI開発における倫理的、法的な問題への対応を促進します。

このように、「GPT-4o」は技術的な進化だけでなく、社会的、文化的な影響も含めて、その将来性が非常に高いと評価されています。

【2024/5/21追記】「GPT-4o」合成音声停止事件:スカーレット・ヨハンソンの声に酷似

Statement from Scarlett Johansson on the OpenAI situation. Wow: pic.twitter.com/8ibMeLfqP8

— Bobby Allyn (@BobbyAllyn) May 20, 2024

OpenAIが発表した最新AIモデル「GPT-4o」に搭載された合成音声が、映画『her/世界でひとつの彼女』でスカーレット・ヨハンソンが演じたAIアシスタントの声に驚くほど似ていると話題になりました。

この問題が明るみに出たのは、スカーレット・ヨハンソン本人からの申し立てによるもので、結果としてその合成音声「Sky」の利用が一時停止されました。

スカーレット・ヨハンソンは声明の中で、「リリースされたデモを聞いて、ショックを受け、怒りがこみ上げました。私の声に非常に似ていることに驚きを隠せませんでした」と述べました。

スカーレット・ヨハンソンの抗議とOpenAIの対応

スカーレット・ヨハンソンの広報担当者を通じて『WIRED』に伝えられた声明によると、OpenAIのサム・アルトマンCEOが昨年9月にヨハンソンに声の提供を依頼しましたが、彼女はこれを断りました。それにもかかわらず、発表された合成音声が彼女の声に非常に似ていることが明らかになり、彼女は法的措置を取ることを検討しました。

サム・アルトマンはX(旧ツイッター)に「her」と投稿し、これがさらに憶測を呼びました。

her

— Sam Altman (@sama) May 13, 2024

スカーレット・ヨハンソンの弁護士がOpenAIに対し、合成音声がどのように作られたのか詳細を求めると、OpenAIは「Skyの声は別のプロの女優のもので、スカーレット・ヨハンソンの声を模倣したものではありません」と反論しました。

OpenAIの公式サイトによると、「Sky」の声はスカーレット・ヨハンソンを真似たものではなく、別のプロの女優の自然な話し声を使用したものであると説明しています。

このサイトには、「AIの声は有名人の声を意図的に模倣すべきではない」との方針が示されており、Skyの声優はプライバシー保護のため公開されていません。

OpenAIは、声優の選定プロセスについても詳細に述べています。5カ月間にわたるオーディションとキャスティングの過程で、400人以上の応募者から選ばれた5つの声がChatGPTに採用されました。これらの声は、ChatGPTのユーザー体験を向上させるために慎重に選ばれました。

しかし、スカーレット・ヨハンソンの声明とOpenAIの説明が一致しなかったため、最終的にOpenAIは「Sky」の声の使用を一時停止する決断をしました。この事件は、AI技術が進化する中で、合成音声の利用に関する倫理的な問題を浮き彫りにしています。

今回の事件は、OpenAIがAI技術の進化とともに直面する新たな課題を象徴しており、今後の開発において重要な教訓となるでしょう。

【2024/6/27追記】OpenAI、ChatGPTの高度な音声モード提供を1ヵ月延期!

OpenAIは6月25日(現地時間)、ChatGPTの高度な音声モードのα版提供開始を当初予定していた6月下旬から1ヵ月延期することを発表しました。

OpenAIは、公式X(旧Twitter)を通じてこの情報を発表し、詳細な理由と今後の計画を説明しました。

We're sharing an update on the advanced Voice Mode we demoed during our Spring Update, which we remain very excited about:

— OpenAI (@OpenAI) June 25, 2024

We had planned to start rolling this out in alpha to a small group of ChatGPT Plus users in late June, but need one more month to reach our bar to launch.…

ChatGPTの高度な音声モードは、AIが人間の感情(音声のトーン)や非言語的な合図を理解することで、リアルタイムでより自然な会話を実現する機能です。

高度な音声モードのα版提供開始までの改善と計画

OpenAIは、特定のコンテンツを検出して応答を拒否する機能や、ユーザーエクスペリエンスの改善に取り組んでいます。これにより、高度な音声モードの信頼性と安全性を確保し、より多くのユーザーが安心して利用できる環境を提供することを目指しています。

今後の計画として、少数のChatGPT Plusユーザーにα版を提供し、フィードバックを収集します。その後、フィードバックに基づいて改善を行い、2024年秋にはすべてのChatGPT Plusユーザーに高度な音声モードを提供する予定です。

また、新しい動画機能と画面共有機能の展開も計画されており、詳細は今後発表される予定です。

これにより、AIとの対話がより人間らしくなり、ユーザーエクスペリエンスが向上することが期待されています。

【2024/9/27追記】ChatGPTの高度な音声モード「Advanced Voice Mode」が全有料ユーザーに提供開始!

OpenAIは2024年9月24日(現地時間)、ChatGPTの高度な音声モード「Advanced Voice Mode」をすべての有料ユーザーに向けて提供を開始すると発表しました。

Advanced Voice is rolling out to all Plus and Team users in the ChatGPT app over the course of the week.

— OpenAI (@OpenAI) September 24, 2024

While you’ve been patiently waiting, we’ve added Custom Instructions, Memory, five new voices, and improved accents.

It can also say “Sorry I’m late” in over 50 languages. pic.twitter.com/APOqqhXtDg

この新機能は、ユーザーがまるで人間と会話しているかのようなリアルタイムで自然な音声対話を可能にし、さらに多言語対応や音声の選択肢が拡充されています。これまで一部のテストユーザー向けに提供されていたこの機能は、今後、ChatGPT PlusやTeamプランの全てのユーザーが利用できるようになります。

高度な音声モード「Advanced Voice Mode」の特徴と新機能

「Advanced Voice Mode」は、従来の音声機能を大幅に進化させ、AIが感情や非言語的な合図を理解してリアルタイムで反応できるように設計されています。この機能は、50以上の言語に対応しており、日本語を含むさまざまな言語で、流ちょうな音声対話が可能です。加えて、以下の新機能が導入されています。

「Advanced Voice Mode」の新機能

- 新しい音声の追加:これまでの4種類の音声に加え、「Vale」、「Spruce」、「Arbor」、「Maple」、「Sol」の5種類が新たに追加され、計9種類の音声が選べるようになりました。それぞれの音声は、プロの声優が提供しており、自然な話し方を追求しています。

- Custom Instructions:ユーザーが事前に設定したカスタム指示に基づいて、ChatGPTの回答方法を指定することができます。これにより、より個別化された会話が可能になります。

- Memory機能:以前の会話を参照し、その文脈を踏まえて新たな応答を生成することができ、より連続した会話体験を提供します。

「Custom Instructions(カスタム指示)」についてはこちらの記事に詳しく解説しています。

「Memory(メモリ)機能」についてはこちらの記事に詳しく解説しています。

スカーレット・ヨハンソンとの論争

なお、「Advanced Voice Mode」の音声に関しては、スカーレット・ヨハンソンさんとの論争が一時期大きな話題となりました。

彼女の声に酷似したAIの音声が使われたことに対して、ヨハンソンさんは自身の声が無断で模倣されたと主張。これを受けて、OpenAIはその音声を停止し、新たな音声を導入する対応を取りました。

OpenAIは、現在提供されている音声はプロの声優によるもので、意図的に著名人の声を模倣することは避けていると説明しています。

提供開始の時期と利用対象

この新しい高度な音声モードの提供は、ChatGPT PlusやTeamプランのユーザー向けに段階的に展開され、今週中に全ての対象ユーザーに利用可能となる予定です。アプリ内でこの新機能が利用できるようになると通知が表示され、すぐに音声対話を開始できます。

ただし、EU、イギリス、スイス、アイスランド、ノルウェー、リヒテンシュタインの地域では、現時点で提供が遅れていることが報告されています。

OpenAIは、今回の新機能の展開とともに、ユーザーからのフィードバックを収集し、さらに改善を続けていく予定です。また、動画機能や画面共有機能も今後のアップデートで追加される見込みです。

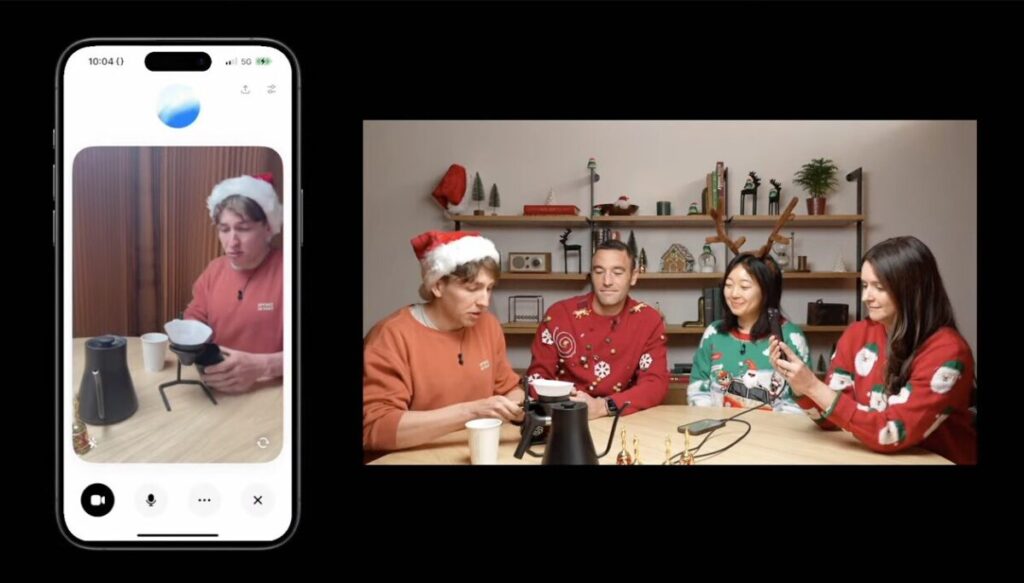

【2024/12/13追記】ChatGPTの「Advanced Voice Mode」が進化!リアルタイムビデオと画面共有機能が追加

Just in time for the holidays, video and screensharing are now starting to roll out in Advanced Voice in the ChatGPT mobile app. pic.twitter.com/HFHX2E33S8

— OpenAI (@OpenAI) December 12, 2024

OpenAIは2024年12月に『12 Days of OpenAI』という連続発表イベントを開催しています。このイベントでは、12日間にわたって毎日新しい機能やサービスが発表されており、AIの可能性をさらに広げる多彩な取り組みが公開されています。

その6日目となる12月13日には、「ChatGPTのAdvanced Voice Mode(高度な音声モード)」の進化が発表され、リアルタイムビデオ機能と画面共有機能が正式に追加されました。この新機能により、ChatGPTとのコミュニケーションが音声だけでなく、映像を活用した新たな次元へと広がります。

リアルタイムビデオと画面共有の新機能とは?

今回の進化により、ChatGPTはユーザーのカメラや画面情報を活用して、より実用的で直感的な支援が可能になりました。

リアルタイムビデオと画面共有の新機能

- リアルタイムビデオ機能

カメラを通じてChatGPTが目の前の状況を認識し、具体的なアドバイスを提供できます。例えば、以下のような場面で利用できます:- 作業サポート:コーヒーメーカーを映しながら「コーヒーの淹れ方を教えて」と尋ねると、ChatGPTがリアルタイムで手順を説明。

- 人物認識:パーティの様子を撮影し、「トナカイの角を被っているのは誰?」と質問すると、ChatGPTが正確に回答。

- 画面共有機能

スマートフォンやデスクトップの画面をChatGPTと共有し、リアルタイムでの相談が可能です。たとえば、メッセージアプリを表示しながら返信内容を相談したり、資料作成中のアドバイスを受けることができます。

「サンタモード」の追加でホリデーシーズンをさらに楽しく

Advanced Voice Modeには、年末限定で「サンタモード」が追加されました。この機能では、サンタクロースの声でChatGPTが応答し、ホリデー気分を盛り上げます。

会話例

- 「サンタクロースが好きなクリスマスの伝統は?」

ChatGPT:「靴下を暖炉のそばに吊るすことだよ!」 - 「お気に入りのトナカイは誰?」

ChatGPT:「もちろんルドルフだよ!でも、みんな特別なんだ。」

サンタモードは2024年12月いっぱい利用可能で、ChatGPTのモバイルアプリやデスクトップ版の設定メニューから簡単に切り替えができます。

いつから、どのプランで利用できる?

- 対応プラン:ChatGPT Plus、Pro、Teamプランのユーザーが利用可能です。EnterpriseおよびEduプランでの利用は2025年初頭を予定しています。

- 利用開始:本機能は現在順次展開中で、対象ユーザーにはアプリ内で通知が届く予定です。ただし、現時点では「Advanced Voice Mode」の進化に伴うリアルタイムビデオ機能や画面共有機能は、英語対応のみで提供されています。日本語対応に関する情報は、今後のアップデートで発表される可能性があります。

『12 Days of OpenAI』は、OpenAIが新たなAI技術を次々に公開する大規模なイベントであり、その6日目に発表された「Advanced Voice Mode」の進化は、AIとのインタラクションをこれまで以上に自然で多彩なものにする重要な一歩となります。

ぜひ新機能を活用して、AIとの新たなコミュニケーション体験を楽しんでください!

「Advanced Voice Mode(高度な音声モード)」と新機能「リアルタイムビデオ」と「画面共有」についてはこちらの記事に詳しく解説しています。

『12 Days of OpenAI』についてはこちらの記事に詳しく解説しています。

【2025/3/28追記】「GPT-4o」に画像生成機能(4o Image Generation)を標準搭載!

4o image generation has arrived.

— OpenAI (@OpenAI) March 25, 2025

It's beginning to roll out today in ChatGPT and Sora to all Plus, Pro, Team, and Free users. pic.twitter.com/pFXDzKhh2t

OpenAIは2025年3月25日(現地時間)、ChatGPTに大規模なアップデートを実施し、「GPT-4o」に画像生成機能(4o Image Generation)を標準搭載したことを発表しました。

アップデートした「GPT-4o」は、は、従来のDALL·E 3とは異なり、ネイティブに画像生成機能「4o Image Generation」を備えています。

これにより、ユーザーはChatGPTと対話をしながら、これまで以上に高品質な画像を、直感的に生成・編集できるようになりました。

以下は、「GPT-4o」の画像生成機能の主な特徴です。

- 正確なテキスト描画:画像内にテキストを自然に組み込むことが可能で、看板やインフォグラフィックなどの作成にも適しています。

- 日本語テキストの描画:日本語を含む多言語のテキスト描画に対応しており、自然なフォントで表示されます。

- 生成する画像の品質が大幅に向上:解像度が高く、写真のようなリアルな描写も可能です。

- 会話形式で修正・調整ができる:画像生成後に追加でプロンプトを入力すれば、画像の修正や調整が可能です。

- 詳細な指示の理解:複数の要素を含む複雑なプロンプトにも対応し、精密な画像を生成します。

- スタイル変換と編集:アップロードした画像を基に、スタイルの変更や要素の追加・削除などの編集が可能です。

- 4コマ漫画:ユーモアやストーリー性を含む4コマ漫画の生成も可能です。

- キャラクターデザイン:ゲームやストーリーテリング用のキャラクターを一貫性を持って生成することが可能です。

- アニメ風の画像作成:例えば自撮り写真をジブリ風スタイルに変換するなどが可能です。

この新機能「4o Image Generation」により、ChatGPTはテキストだけでなく、画像を通じた様々な表現も可能となり、より豊かな活用方法が期待できます。

「GPT-4o」の新機能「画像生成(4o Image Generation)」についてはこちらの記事に詳しく解説しています。

【2025/4/1追記】「GPT-4o」がアップデート!より直感的で高性能に進化

GPT-4o got an another update in ChatGPT!

— OpenAI (@OpenAI) March 27, 2025

What's different?

– Better at following detailed instructions, especially prompts containing multiple requests

– Improved capability to tackle complex technical and coding problems

– Improved intuition and creativity

– Fewer emojis 🙃

OpenAIは2024年3月27日(現地時間)、ChatGPTで使われている「GPT-4o」モデルに新たなアップデートを実施したと発表しました。今回のアップデートでは、複雑な指示への理解力が大幅に強化され、より直感的で創造的な応答が可能になりました。

アップデート内容のポイント

以下に、今回の「GPT-4o」の主な改良点をわかりやすくまとめます。

| 改善点 | 内容 |

|---|---|

| 複雑なプロンプトへの対応力強化 | 複数のリクエストを含む長文指示にも、より正確に対応できるようになりました。 |

| 技術・コーディングの精度向上 | フロントエンドコードの生成、既存コードの分析・修正提案、実行可能な出力の一貫性が向上。 |

| 出力の直感性と創造性の強化 | 回答のアイデアや表現が、より自然で多様になり、創造的な応答がしやすくなりました。 |

| Markdown階層や絵文字の最適化 | 絵文字の使用を最小限に抑え、構造が明確で読みやすいテキスト出力が可能になりました。 |

| 分類タスク・出力フォーマットの改善 | 指定された形式に沿った出力や、分類・整理の精度が向上しています。 |

特に、エンジニアや技術系ユーザーにとっては、コードの品質向上や読みやすさの改善により、開発ワークフローがさらに効率化される点が注目されています。

利用できるプランと展開状況

今回のGPT-4oアップデートは、以下の有料プランですでに利用可能となっており、無料プランユーザーにも今後数週間以内に順次展開される予定です。

対象プラン

- ChatGPT Plus

- ChatGPT Team

- ChatGPT Enterprise

- ChatGPT Edu

アップデートはChatGPT内で自動的に反映されているため、特別な設定は不要です。すでに利用中の方は、これまでと同じように「GPT-4o」を選択するだけで、より賢くなった「GPT-4o」を体験できます。

まとめ

「GPT-4o」の最新AIモデルがもたらす多様な機能と進化について解説した本記事では、「GPT-4o」の革新性とその実用的なデモンストレーションを詳しくご紹介しました。

音声、画像、テキストのシームレスな統合が可能となり、日常生活や業務プロセスに革命をもたらす「GPT-4o」は、リアルタイムの自然な対話を実現し、マルチモーダルな応答でユーザー体験を向上させます。

また、無料ユーザーにも多くの機能が提供され、macOS用のデスクトップアプリも導入されました。これらの機能拡充により、より多くのユーザーがAIの恩恵を受けることができます。

最後に、次世代AIモデル「GPT-4o」の重要なポイントをまとめます。

次世代AIモデル「GPT-4o」の重要なポイント

- マルチモーダル統合機能の進化:「GPT-4o」はテキスト、画像、音声をシームレスに統合し、リアルタイムでの自然な対話を実現しました。これにより、ユーザーはよりダイナミックで直感的な体験を享受できます。

- リアルタイム翻訳機能の向上:多言語に対応した翻訳機能により、言語の壁を超えたコミュニケーションが可能になり、国際会議や教育分野での活用に期待できます。

- 数式解析機能の提供:複雑な数式を理解し段階的に解答を導く能力を持つことで、教育や研究分野での利用が進んだり、学習支援や専門的な分析が強化されたりするでしょう。

- 視覚と感情認識の精度:視覚データから感情を読み取る能力により、ユーザーの感情に対する理解が深まり、カスタマーサービスやソーシャルメディアの分析に革新をもたらします。

- APIの高速化とコスト削減:開発者向けのAPIが高速化され、コストが削減されたことで、より多くの開発者が手軽に先進的なAI技術を利用できるようになります。

- 無料ユーザーとChatGPT Plusユーザーの違い:無料ユーザーは「GPT-4o」の基本機能にアクセスできますが、リソースの制限があります。一方で、ChatGPT Plusユーザーは音声会話機能や画像生成機能を含む全機能にアクセス可能で、応答速度が速く、より多くのメッセージを送信できるというメリットがあります。これにより、PlusユーザーはAIをより効果的に活用できる環境が整っています。

- ChatGPTデスクトップアプリの導入:macOS用デスクトップアプリの導入により、ユーザーはPCから直接AIと対話できるようになり、利便性が向上します。

「GPT-4o」の導入により、私たちの日常やビジネス環境は大きく変わることが期待されます。

この次世代AIモデル「GPT-4o」の技術の進化を利用し、新たな可能性を探求するチャンスをぜひ活かしてください。

ChatGPT モデルの比較と一覧

ChatGPTは「GPT-4o」や「GPT-4.1」、「GPT-4.5」など、複数のモデルが提供されており、それぞれに特徴や得意分野があります。

どのモデルが自分に合っているのか、どう使い分ければよいのか迷っている方も多いのではないでしょうか?

そんな方のために、GPT-4o・GPT-4.1・GPT-4.1 mini・GPT-4.5・o3・o4-mini・o4-mini-high・o1-pro mode、といったモデルの違いや用途をわかりやすく解説した比較記事をご用意しました。

「モデル一覧・比較表」と「目的別の選び方」が一目でわかる完全ガイドになっています。

ChatGPTを最大限に活用するには、モデルの選び方が非常に重要です。ぜひこちらの記事をチェックして、自分にぴったりのモデルを見つけてください。

-300x158.jpg)

最後までお読みいただきありがとうございました!

コメント